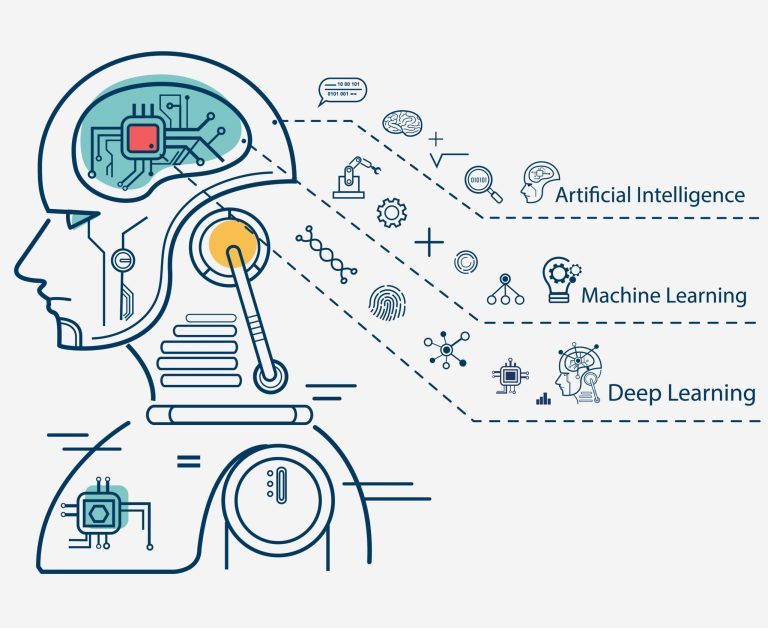

L’intelligente artificielle et le Deep Learning sont au coeur des discussions technophiles actuelles. Mais au-delà des fantasmes technophobes, une question demeure : peut-on et faut-il rendre une machine intelligente ? Quelles en seraient les conséquences sur votre humanité ?

Ordinateur et intelligence artificielle

Les premiers ordinateurs était des machines que peu de personnes auraient pu désigner comme intelligentes. De simples calculateurs à cartes perforées qui comptaient et classaient dès la fin du XIXème siècle. La deuxième génération ne fut pas plus intelligente. Mais le fait qu’elle soit programmable, qu’on lui fournisse des instructions pas à pas pour effectuer des tâches, nos fameux algorithmes, était déjà une nette avancée. L’ENIAC, premier ordinateur électronique utilisé dans les années 50 aux États-Unis, en fut l’illustration. L’intelligence, qu’elle qu’en soit sa nature et sa forme, humaine ou artificielle, suppose cependant la capacité d’apprendre. C’est là que la troisième génération entre en jeu de nos jours, elle sera auto-apprenante ou ne sera pas.

De l’intelligence artificielle à l’intelligence augmentée

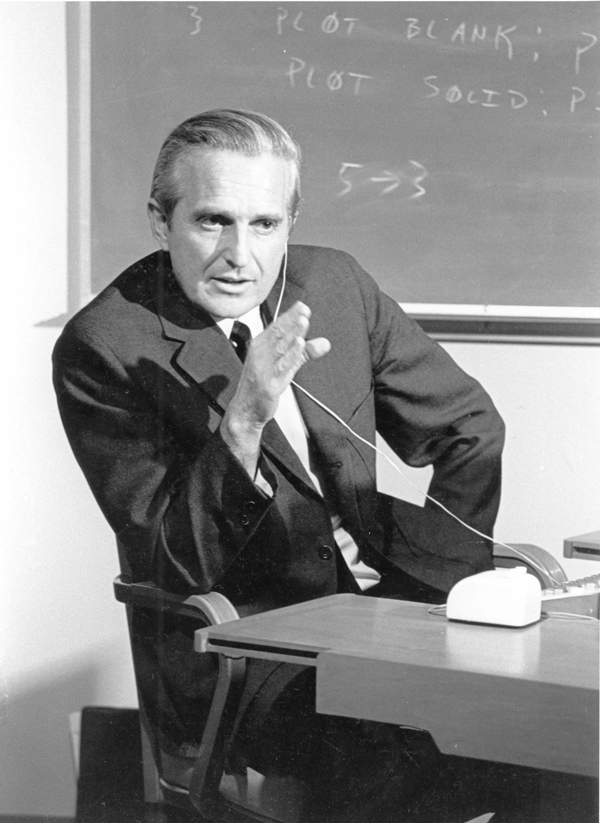

Développer une intelligence artificielle, IA pour les fans d’acronyme, est bien plus complexe qu’il n’y parait. Plus de soixante ans après la création du test d’Alan Turing, via lequel une machine ne pourrait être distinguée d’un humain dans un questionnaire, il faut bien admettre qu’aucune machine pensante n’a encore vu le jour. Si ce n’est au cinéma sous la forme angoissante du Hal de 2001, L’Odyssée de l’espace. Lorsque l’intelligence artificielle fut lancée en tant que domaine scientifique en 1956 au Dartmouth College, John McCarthy et Marvin Minsky pensaient que développer une IA aboutirait à copier le fonctionnement du cerveau. Le fruit de ces recherches aboutit au concept du Perceptron qui resta à l’état de projet et ne vit jamais le jour. Plutôt qu’une machine intelligente, la voie qui s’ouvre à nous ressemble bien plus à une collaboration, un processus que Douglas Engelbart définissait comme une « coévolution » entre l’homme et la machine.

De la symbiose homme-machine…

Un des actes fondateurs des innovations liées à l’intelligence artificielle fut « la Mère de toutes les démos » en décembre 1968 par Engelbart. Il s’était choisi pour mission d’inventer des moyens par lesquels l’informatique pourrait augmenter l’intelligence humaine. Fortement influencé par le memex de Vannevar Bush (Life, « Comme nous pouvons le penser »), un concept de système personnel de stockage et de partage d’informations, il chercha à mettre au point dès 1950 un système qui permettrait aux humains de gérer la complexité auquel il donna le nom d’intelligence augmentée. À partir de 1957, il travailla au SRI (Stanford Research Institut) qui cherchait à créer un sysfème qui imiterait les réseaux de neurones du cerveau humain. Engelbart y poursuivait une autre voie, non pas remplacer la pensée humaine par une intelligence artificielle, mais combiner l’esprit intuitif de l’individu avec les capacités de traitement de la machine dans une symbiose entre l’humain et l’ordinateur, idée énoncée en 1960 par Licklider dans son article « La symbiose homme-ordinateur ». Engelbart décrivit sa vision en 1962 dans l’ouvrage « Augmenter l’intellect humain » et y reprit l’idée de Bush qu’ordinateur et humain pourraient interagir en temps réel au travers d’interfaces simples comprenant des écrans graphiques, des curseurs et des dispositifs de saisie. Cette conception de l’interaction homme-machine s’est quelque peu infléchie depuis quelques années vers une limitation de l’interface graphique au profit de l’interface vocale jusqu’à s’affranchir peut être un jour de l’écran. On songe en cela à la reconnaissance vocale des assistants virtuels tels que Siri d’Apple, Cortana de Microsoft ou celle de Google bien entendu. Mais l’écran demeure. Amazon a ouvert une brèche dans l’appel à l’écran avec le lancement il y a quelques années de l’Amazon Echo et son interface vocal. Suivi depuis quelques mois par Google. Mais le chemin est encore long pour faire passer la machine du rang d’assistant à celui de compagnon naturel.

À la cohabitation homme-machine ?

De la notion de symbiose homme-machine découle celle d’écosystème, donc d’équilibre, entre notre part d’humanité et la machine. D’où le fantasme d’une espèce hybride humanoïde ou la quête des transhumanistes pour augmenter l’Homme, le rendre « réparable », « l’optimiser » comme tous solutioniste de la Silicon Valley en rêve. Mais comment faire cohabiter l’homme et la machine ? Doit-elle rester une composante mécanique, organique, comme une prothèse ou un exosquelette ? Où faudrait-il envisager qu’elle partage notre cognition ?

Cette cohabitation possible soulève par ailleurs d’autres questions. Il est assez étonnant de constater que lorsque un humain bouscule un chien robot avec un coup de pied pour le déstabiliser – et prouver ainsi la performance de ses programmes algorithmiques qui calculent en temps réel sa position pour qu’il ne tombe pas – nous faisons preuve d’empathie pour la machine (j’ai d’ailleurs faillit écrire « lorsque un humain maltraite un chien robot »). Face à ces images, on ne peut s’empêcher de voir l’humain comme un bourreau alors que la machine n’éprouve ni douleur ni émotion.

À l’heure actuelle, combien même les recherches en intelligence artificielle avancent à grand pas, elle reste encore à un stade embryonnaire de son développement. Quoi que… Google vient d’annoncer que dans le cadre de ses recherche sur le Deep Learning, à savoir la manière dont des ordinateurs peuvent évoluer de façon autonome grâce à des algorithmes, son programme de recherche en intelligence artificielle Google Brain vient de franchir un grand cap. Comme nous le précise le Science Post,

« les chercheurs sont parvenus à faire communiquer deux IA nommées Alice et Bob entre elles, alors que de son côté, une troisième IA du nom d’Eve avait pour but d’intercepter leurs communications. Alors qu’ils n’avaient mis aucun algorithme spécifique en place, les chercheurs ont constaté que ces deux ordinateurs ont sécurisé leurs communications par le biais d’un chiffrement qu’ils avaient eux-mêmes développé. Si la troisième IA est parvenue à intercepter certaines communications, la majorité d’entre elles sont restées indéchiffrables. Ce n’est là qu’un début, mais cela donne une idée du futur des intelligences artificielles qui pourront ainsi être capables de communiquer dans un langage unique que nous ou d’autres ordinateurs ne pourrons peut-être pas déchiffrer ».

Science Post

De telles avancées techniques sont, certes, remarquables, mais s’inscrivent dans un contexte de laboratoire, bien loin due toute autonomie. Sarah Connor peut ouvrir sa porte sans sortir son flingue et Skynet retourner à ses calculs.